ReduceJoin 的工作:

Map 端的主要工作:为来自不同表或者文件的 KV 对,打标签以区别不同来源的记录,然后用连接字段作为 key,其余部分和新加的标志位作为 value,最后进行输出。

Reduce 端的主要工作:在 Reduce 端以连接字段作为 key 的分组已经完成,只需要在每个分组中,将那么来源于不同文件的记录分开,最后完成合并即可。

ReduceJoin

示例

需求:输入数据为两个表:订单、商品信息,将商品信息中的数据,根据商品的 pid,合并到订单数据中。

TableBean

1 | public class TableBean implements Writable { |

Mapper

1 | public class TableMapper extends Mapper<LongWritable, Text, Text, TableBean> { |

Reducer

1 | public class TableReducer extends Reducer<Text, TableBean, TableBean, NullWritable> { |

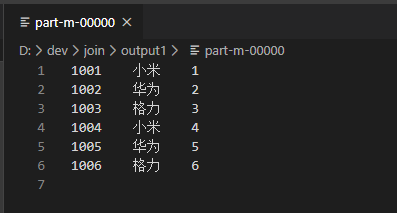

省略 Driver,查看运行结果

缺点

合并的操作在 Reduce 阶段完成,Reduce 端的处理压力太大,Map 节点的运算负载很低,资源利用率不高,而且在 Reduce 阶段极易产生数据倾斜。 推荐使用 MapJoin

MapJoin

适用场景: 一个张表十分小,一个表十分大

优点

在 Map 端缓存多张表,提前处理业务逻辑,增加了 Map 业务,减少 Reduce 数据压力,尽可能减少数据倾斜

方法

1、在 Mapper 的 setup 阶段,将文件读取到缓存集合中

2、在驱动函数中加载缓存

实现

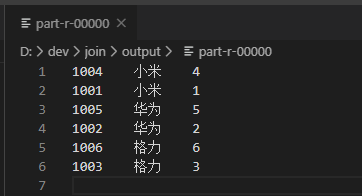

依然使用上例中的输入数据,输入结果也应该与上例一致。

Driver

由于 MapJoin 不需要 Reduce 端,此时可以将 Driver 中的 MapperKeyClass、MapperValueClass、ReduceClass 去掉

1 | public static void main(String[] args) throws Exception { |

Mapper

1 | public class MapJoinMapper extends Mapper<LongWritable, Text, Text, NullWritable> { |

查看结果